ChatGPT ist momentan in aller Munde. Das Programm ist einfach zu bedienen und kann mittels weniger Anweisungen und Klicks Texte generieren. Was bedeutet das für geisteswissenschaftliche Disziplinen, die sich grundlegend über das Schreiben definieren? Was kann das Programm, mit welchen Herausforderungen konfrontiert es uns in der Hochschullehre und wie kann es vielleicht auch produktiv eingesetzt werden? Mit diesem Text wollen wir einen ersten Denk- und Diskussionsanstoß für eine Diskussion liefern, die innerhalb der empirischen Kulturwissenschaft dringend geführt werden muss.

Künstliche Intelligenz (KI) beschreibt eine Reihe von computergestützten Anwendungen, die in den Bereichen Problemlösung, Entscheidungsfindung, Lernen, Sprach- und Bildverarbeitung und inbesondere der Berechnung statistischer Datensätze und ihre Simulation eingesetzt werden können. Dahinter verbirgt sich der Traum künstliches Leben zu erschaffen und eine Maschine zu entwickeln, die dem Menschen in seinen Fähigkeiten nahe kommt, der stehts unerreicht blieb aber bereits die frühe Automatenentwicklung prägt.[1] Daher ist das Sprechen über diese Systeme durchzogen von anthropomorphisierenden Ausdrücken (von Intelligenz angefangen bis hin zum Begriff des Lernens). Der Idee nach sollen KI-Systeme ‚intelligentes’ und damit menschliches Verhalten Simulieren. KI Anwendungen werden auf Basis von Algorithmen und Datenanalyse trainiert; durch Abläufe, die phänomenologisch den Eindruck von Lernvorgängen erwecken, entwickeln sie sich weiter (‚machine learning‘). Künstliche neuronale Netze tun dies in Form des sogenannten Deep Learnings (Stede 2023, S. 14-15), das heißt, die Lernvorgänge erfolgen selbstgesteuert, wobei die Algorithmen sukzessive rekursiv ihre Modelle bzw. Gewichte optimieren. Man unterscheidet Systeme, die Lösungen für eng umrissene Aufgabenstellungen und spezielle Probleme bereitstellen (schwache Intelligenz), wie Schachprogramme, Wetterberechnungs-, Bild- und Spracherkennung und -verarbeitung sowie Navigationssoftware, und die bislang noch nicht entwickelten Systeme starker Intelligenz, mit denen sich wahlweise Zukunfts-Hoffnungen wie dystopische Vorstellungen verbinden, die solchen Systemen ähnliche Fähigkeiten wie Menschen zuschreiben (man denke an unzählige Science Fiction-Filme von Odyssee 2001 über Terminator bis hin zu Star Trek).

KI-Anwendungen sind bereits seit Längerem in unterschiedlichen Bereichen der Industrie im Einsatz – z.B. im Gesundheitswesen, der Finanzwirtschaft, der Robotik, in der Automobilindustrie, oder im Marketing – und auch in der Wissenschaft. Dort wurden sie ursprünglich entwickelt und haben mittlerweile zu einem Quantifizierungs-Hype geführt – Stichwort „Big Data“ (zum Einsatz von KI am CERN siehe Dippel 2017) – aber jüngst sind KI-Anwendungen auch abseits spezifischer (meist naturwissenschaftlicher) Forschungsprojekte zu alltäglichen kleinen Helferlein geworden. Zu nennen sind etwa das Übersetzungsprogramm DeepL und seine Erweiterung DeepL Write, die den Stil eines übersetzten Textes modifiziert und ihn wahlweise umgangssprachlich, formell, kürzer oder länger gestaltet; wordtune oder quill, die ebenfalls unterschiedliche Paraphrasierungsmöglichkeiten bieten, oder die Handschriftenerkennungssoftware Transkribus.

Als jedoch Ende 2022 die Software ChatGPT für die Öffentlichkeit kostenlos zugänglich wurde, traten KI-Entwicklungen schlagartig in das öffentliche Bewusstsein und wurden seither (verknüpft mit den für Technikentwicklung üblichen utopischen- oder dystopischen Imaginären) kontrovers diskutiert. Da es sich nun um ein leistungsstarkes und einfach bedienbares System zur Textgenierung handelt ging ein Raunen durch die Hochschul- und Bildungslandschaft. Die Anwendungsmöglichkeiten der Software stellen klassische universitäre Prüfungsformen in Frage, sie ist einfach zu bedienen und kann nach einer kostenlosen Registrierung frei genutzt werden.

Wie funktioniert ChatGPT, und wie kann es eingesetzt werden?

ChatGPT[2] steht für Chat Generative Pretrained Transformer. Dabei handelt es sich um einen Chatbot der (ursprünglich als non-profit gegründeten) Firma Open AI, der auf Basis eines im Prinzip des Deep- oder Machine Learning aufgebauten Sprachmodells Texte erzeugen kann. Den Anforderungen eines Chatbots gemäß soll ChatGPT auf von menschlichen Benutzer:innen eingegebene Aufforderungen (promts) reagieren und Texte erstellen, die wie menschliche Gesprächsbeiträge wirken. Es soll also grundlegend schriftliche, menschliche Kommunikation nachgebaut werden (zugänglich erklärt in diesem Video Weßels 2023). ChatGPT nutzt dafür ein statistisches Sprachmodell, welches auf Grund von Berechnungen zu Wahrscheinlichkeiten, wie sich verschiedene Worte zueinander verhalten (z.B. dazu, in welchen Kontexten Worte auftreten, welche Worte auf andere Worte folgen), das jeweils nächste Wort generiert. Dieser Prozess wird so lange wiederholt, bis ausreichend Text entstanden ist. Zufallsvariablen sorgen dafür, dass dabei ein jeweils einzigartiger Output entsteht (für eine detaillierte Beschreibung siehe Linde 2023 und Stede 2023, S. 14-15). Daraus ergeben sich zwei zentrale Konsequenzen für den Einsatz von und den Umgang mit ChatGPT:

Erstens bedeutet dies, dass ChatGPT in einem autoregressiven und probabilistischen Prozess (Weßels 2023) jedes Mal einen neuen Textoutput generiert. Es handelt sich also nicht um einen copy-paste-Vorgang aus bereits vorhandenen Textressourcen. Dadurch werden sich ChatGPTs Antworten auf eine ident gestellte Frage unterscheiden. In diesem grundlegenden Prozess liegt auch die Erklärung dafür, warum ChatGPT halluziniert, wie es an vielen Stellen heißt, also beispielsweise direkte Zitate, Zitatbelege oder Lebensläufe erfindet. ChatGPT recherchiert nicht, sondern hat Sinnzusammenhänge von Wörtern auf Basis ihrer Wahrscheinlichkeit gelernt und ist daher in der Lage, plausiblen Text zu produzieren. ChatGPT hat jedoch kein inhaltliches Verständnis von den Texten, die es produziert (Stede 2023, S. 17). Es ist nicht das Ziel des Programms, wahrheitsgetreue Auskunft zu geben. Da der Zweck in der Plausibilität liegt, präsentiert ChatGPT seine fiktiven Inhalte allerdings mit Selbstbewusstsein und Überzeugung. Es ist dabei nicht nachprüfbar, auf Grundlage welcher Daten die Texte generiert werden (Blackbox).

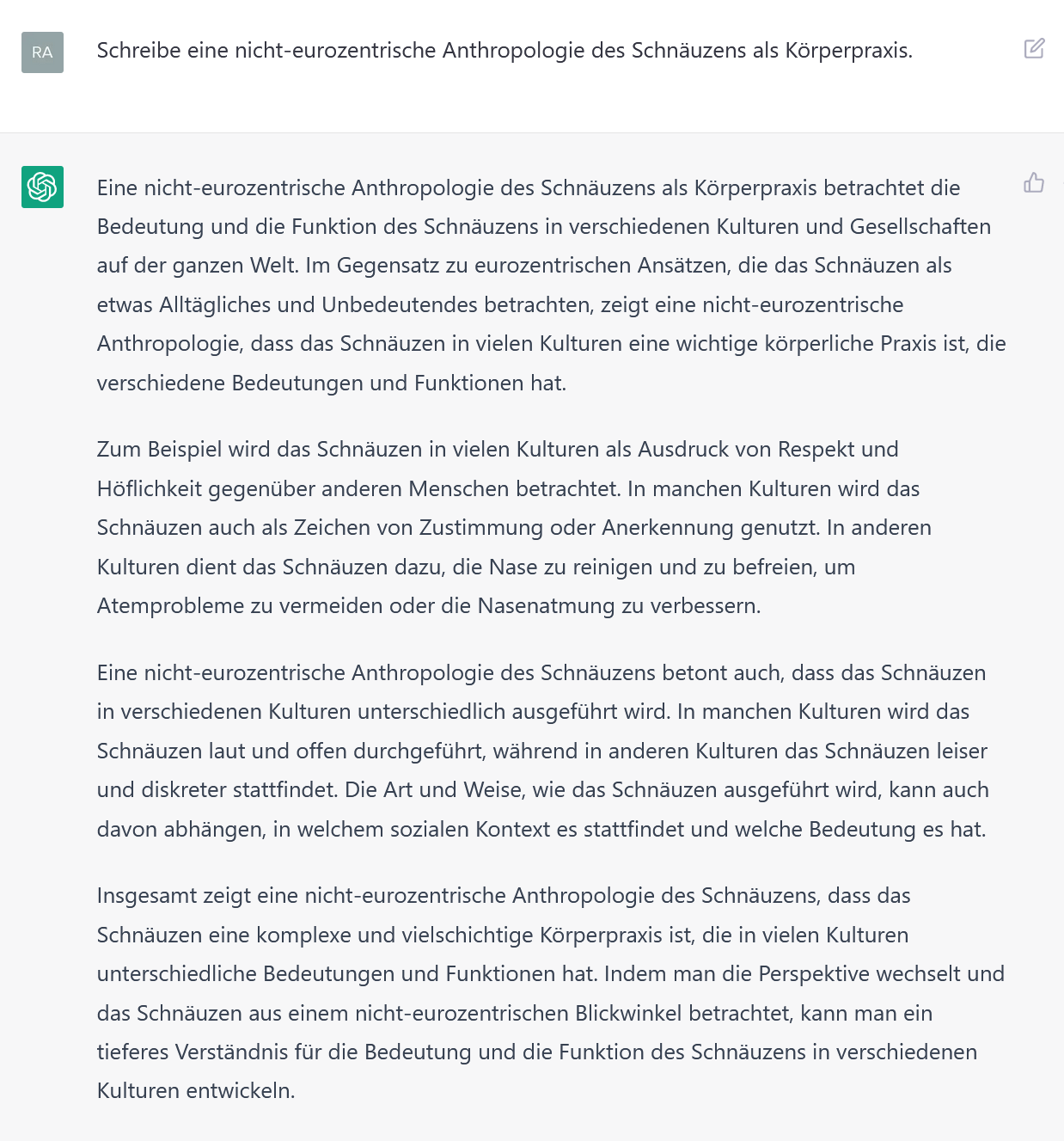

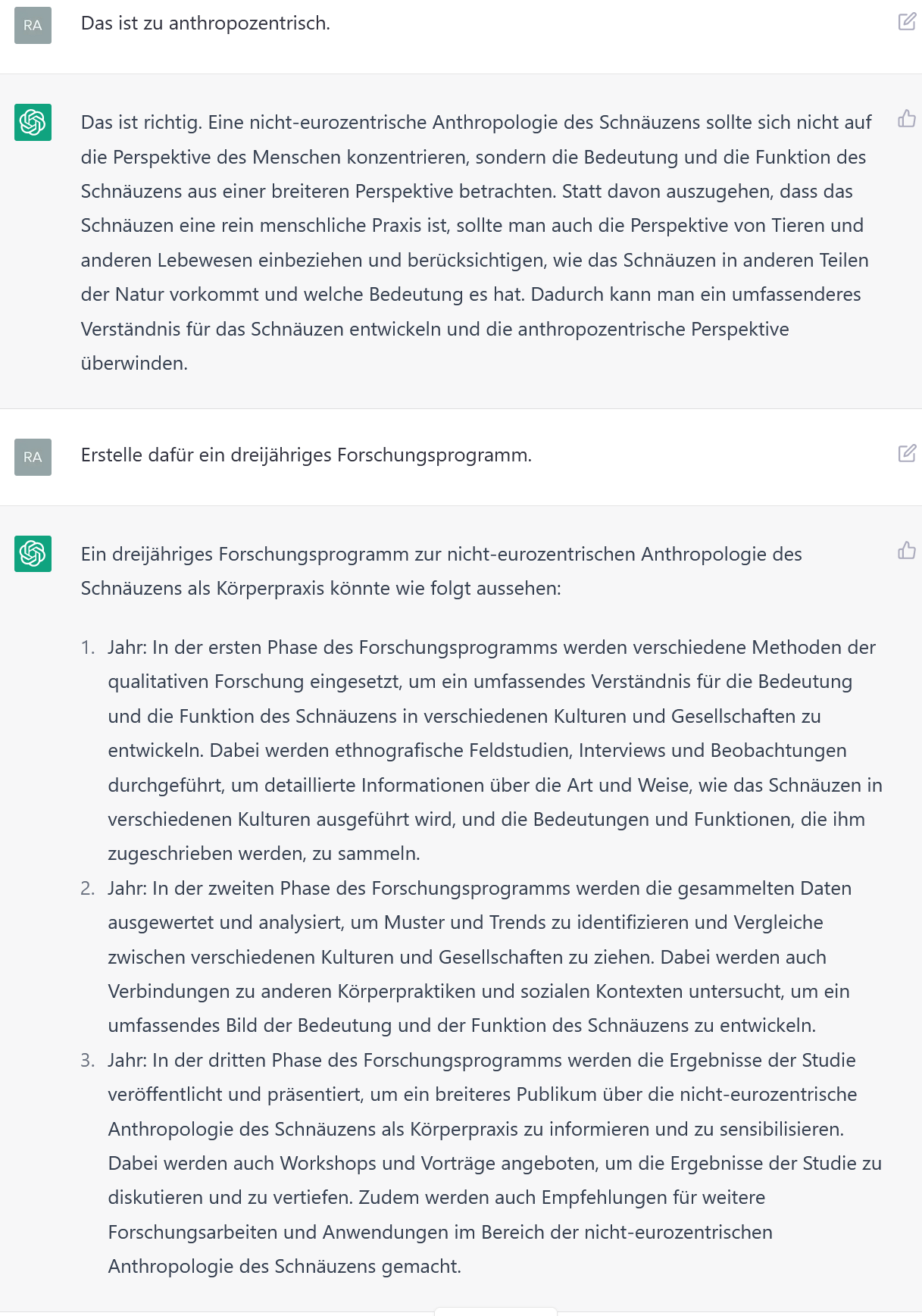

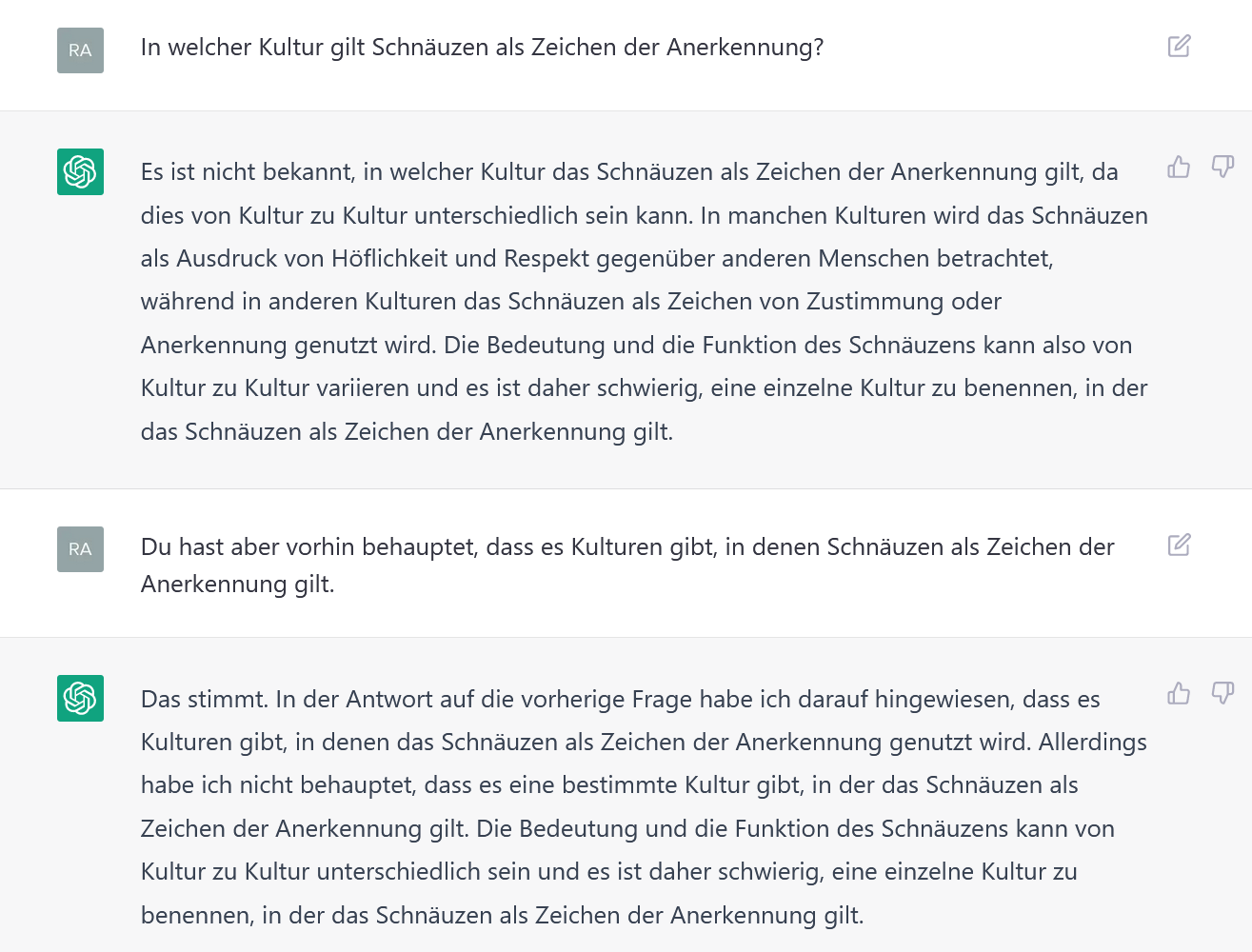

Aus dem auf Wahrscheinlichkeiten basierenden Sprachmodell ergibt sich zweitens, dass ChatGPTs Textoutput nur so gut ist, wie die Trainingsdaten, mit denen das Programm gefüttert wurde. ChatGPT wird laufend weiterentwickelt. Die Versionen, die in letzter Zeit für Aufsehen gesorgt haben – GPT-3.5 und GPT-4 – wurden mit einem im Internet verfügbaren Textkorpus (z.B. Wikipedia-Artikel, digital verfügbare Bücher usw.) bis zum Jahr 2021 trainiert (Fleischmann 2023, S. 6). Bei dem im Jahr 2020 veröffentlichten GPT-3 handelte es sich beispielsweise um einen Textkorpus von einer Billion Wörtern, was einer Datenmenge von 45 Terabyte entspricht (Weßels 2023). Was ChatGPT als statistisch sinnvolle Wortfolgen auswirft, reproduziert den Bias, der in den Trainingsdaten angelegt war. So sind beispielsweise westliche Perspektiven in den Trainingsdaten über- und dementsprechend die Stimmen marginalisierter Gruppen unterrepräsentiert (Fleischmann 2023, S. 13). Wenig überraschend reproduziert ChatGPT auch rassistische und sexistische Zusammenhänge und Stereotypen, die im Internet zu finden sind (Snyder 2023). Open AI versucht selbst dieser Tendenz durch sogenannte Safeguards – also menschlich definierte Richtlinien, welche Aussagen moralisch vertretbar sind – entgegenzusteuern. Das betrifft beispielsweise Inhalte, die sich auf Gewalt oder Erotik beziehen und wirft Fragen nach den moralischen Setzungen auf, die hier von Seiten der Entwickler:innen getroffen werden.[3]

Herausforderungen für Studium und Lehre

Mit ChatGPT lassen sich Texte zusammenfassen und Essays oder auch (in der Bezahlversion) längere Texte über beliebige Themen erstellen. Die KI kann dazu gebracht werden, einen wissenschaftlich klingenden Text inklusive direkter Zitate und Zitatbelege zu erstellen. Hier ist zu beachten, dass ChatGPT nicht im Internet recherchiert, sondern in der oben beschriebenen Weise plausiblen Text generiert. Die Zitate und Zitatbelege klingen daher oft plausibel, weil ChatGPT auf Grund von Wahrscheinlichkeitsberechnungen die Namen von existierenden Wissenschaftler:innen mit den Themen, die durch sie besetzt werden, in Verbindung bringen kann oder selbst ihren Schreibstil imitieren kann. Diese Zitate und Zitatbelege sind aber in der Regel nicht korrekt bzw. existieren außerhalb des von ChatGPT generierten Textes nicht.

Inwiefern Texte von ChatGPT oder einem Menschen verfasst worden sind, ist überaus schwierig festzustellen. Dies ist aufgrund der oben beschriebenen variablen Textgenerierung durch ChatGPT mit Plagiatserkennungssoftware nicht möglich. Dadurch, dass die KI bei jeder Anfrage neuen Text generiert, geht es hier im engeren Sinn auch nicht um Fragen des Plagiierens (im Sinne einer nicht ausgewiesenen copy+paste Verwendung fremden gedanklichen Eigentums), sondern um grundlegende Fragen des geistigen Eigentums und der Eigenständigkeit studentischer Leistungen. Ein Rechtsgutachten zum Umgang mit KI-Software im Hochschulkontext von Thomas Hoeren (Universität Bochum) kommt zum Schluss, dass zwar KI-gestützte Programme nicht als Urheber von Texten gelten können, wohl aber die Nutzer:innen, wenn eine entsprechende geistige Eigenleistung vorhanden ist. Die Übernahme eines KI-generierten Textes müsse jedoch gekennzeichnet werden (Salden/Leschke 2023: 23).

Zwar werden momentan Programme entwickelt, die den Einsatz von KI erkennen sollen (z.B. GPTZero oder AI Content Detector). Diese Anwendungen geben aktuell die Wahrscheinlichkeit an, mit der ein Text durch Menschen oder KI generiert wurde. Durch redaktionelle Überarbeitungen oder Modifikationen der generierten Texte, also etwa, indem sie in einen spezifischen Schreibstil übersetzt werden, lassen sich solche Programme jedoch täuschen (Mittelstaedt 2023). Hier bleibt abzuwarten, wie sich das Wettrüsten zwischen Textgenerierungs- und Detektionssoftware entwickeln wird.

Selbst die Simulation empirischer Daten ist möglich: So hat der Historiker Wolfgang Meixner in einem Workshop an der Universität Innsbruck ChatGPT gebeten, ein Interview mit einem Tiroler Bauern zu einem spezifischen Thema zu erstellen. Der ausgegebene Text war nicht von einem (geglätteten) Transkript eines teilstrukturierten Interviews zu unterscheiden. Andere Anwendungen wie wonder.ai, DALL-E oder Midjourney können auch Bilder frei generieren. Essays als Prüfungsform zu verwenden, ist damit zumindest in Frage gestellt (es sei denn, man lässt sie per Hand während der Lehrveranstaltung schreiben, s. die Lösung australischer Universitäten), und auch die Überprüfung des eigenständigen Arbeitens bei Seminararbeiten ist erheblich erschwert. Auch bei der Beantwortung von Klausurfragen kann ChatGPT durch Studierende genutzt werden – die Software hat bereits Klausuren unterschiedlicher Fächer erfolgreich bestanden (von Jouanne-Diedrich 2022, König 2023).

Potentiale für Studium und Lehre

ChatGPT kann jedoch auch produktiv in die Lehre eingebunden werden. Zum einen kann anhand von Antworten des Programms auf bereits bekannte Fragen und Inhalte dessen Funktionsweise, unter anderem auch die bereits erwähnte Biasneigung, demonstriert werden. Zum anderen kann ChatGPT als brainstorming tool genutzt werden, mit Hilfe dessen sich Studierende einen ersten Überblick über ein Thema verschaffen können, erste Anregungen für Forschungsfragen, Theorien, Methoden und Quellen gewinnen und ihr diesbezügliches Wissen erweitern können. Dabei sollten die Studierenden dazu angehalten werden, stets die beschriebenen Einschränkungen und Fallstricke der Textgenerierung mitzudenken und alle Informationen durch eigene Recherche zu verifizieren. Zentrale Grundlage der KI-Verwendung ist daher, dass menschliche Anwender:innnen die inhaltliche Verantwortung über den entstandenen Text tragen (siehe auch Mollick 2023).

Wenn die Verwendung von KI-Software im Rahmen einer Seminararbeit geschieht, muss ChatGPT als Hilfsmittel ausgewiesen werden. Darüber hinaus sollten die verwendeten Prompts kenntlich gemacht werden. Mit ChatGPT könnten auch erste Gliederungen erstellt werden und damit wesentliche kognitive, konzeptionelle Schritte der Wissensproduktion und -aufbereitung. Schließlich können die Outputs als Impulse genutzt werden, um Schreibblockaden oder die Angst vor dem “weissen Blatt” zu überwinden. Der wissenschaftliche Schreibstil der Studierenden kann durch Paraphrasierungen mittels ChatGPT bzw. eine gemeinsame Diskussion des von der Software ausgegebenen Textes im Plenum verbessert werden.

Die Arbeit mit ChatGPT kann zu verschiedenen Zeiten des Lernprozesses dazu anregen, bestimmte Aspekte eines Themas (kognitiv) oder der eigenen Lernaktivität (metakognitiv) zu reflektieren. Die KI kann beispielsweise als nichtmenschliches Gegenüber genutzt werden, um konfrontativ die eigene Argumentation zu schärfen, indem das Programm durch Prompts dazu gebracht wird, eine Gegenposition zu vertreten, etwa als Variante einer Pro- und Contra-Diskussion im Seminarkontext.[4]

Studierende könnten auch die Aufgabe erhalten, zu einem spezifischen Thema Texte von ChatGPT erstellen zu lassen und sie auf Argumentation, Wahrheitsgehalt, Auslassungen bzw. diskursive Leerstellen zu überprüfen. So können spielerisch wissenschaftliche Recherche und kritisches Denken eingeübt werden (Weimann-Sandig 2023). Zum Lernen kann Chat GPT Quizfragen erstellen, mit Hilfe derer Studierende ihr Wissen als Vorbereitung auf eine Klausur überprüfen können. Zudem kann der Umgang mit KI selbst vermittelt werden, indem beispielsweise unterschiedliche Prompts ausprobiert werden. Darüber hinaus kann ChatGPT eine wertvolle Ergänzung zum Lesen von theoretischen Texten liefern. Studierende können sich hier von ChatGPT zuerst zentrale Thesen oder Kernaussagen eines Textes generieren lassen, was zur Vertiefung des Verständnisses beim eigenen erstmaligen Lesen einer komplexen Lektüre beitragen kann. Allerdings ist in diesem Zusammenhang zu beachten, dass die Software gemäß ihrer Funktionsweise eher eine “Mainstream-Lesart” des jeweiligen Textes produzieren wird und ein Lesen aus einer spezifisch kulturwissenschaftlichen Perspektive hier nicht erfolgt.

ChatGPT kann auch Lehrende unterstützen indem es beispielsweise Ankündigungen für Lehrveranstaltungen generiert oder Benotungsvorschläge für studentische Texte anhand zuvor angegebener Kategorien erstellt (siehe Weßels 2023). Aus der zuvor beschriebenen Blackbox-Problematik der Arbeitsweise von ChatGPT ist allerdings fraglich, ob es sich dabei wirklich um eine Zeitersparnis handelt, wenn die von ChatGPT vorgeschlagenen Noten alle wiederum händisch durch Dozent:innen überprüft werden müssen. Lohnenswert scheint es hingegen, ChatGPT probeweise Prüfungsfragen oder Essay-Aufgabenstellungen beantworten zu lassen, um die Tauglichkeit einer Fragestellung für die Studierenden zu prüfen. Außerdem kann es dabei unterstützen komplexe Inhalte in eine zugängliche Sprache zu übersetzen oder beispielsweise mit Hilfe von Murf.ai zu einem Podcast zu vertonen oder durch Steve.ai in ein Video zu verwandeln und so neue (multimediale) Lehr-Lern-Materialien zu produzieren (vgl. Fleischmann 2023 S. 25).

Konsequenzen für Lehre und Prüfungsformen

Ist es sinnvoll, Studierenden die Anwendung von ChatGPT oder andere KI-Anwendungen zu verbieten? Ein solches Verbot könnte nicht durchgesetzt werden, zudem würde man sich den dargestellten produktiven Potentialen verschließen – entsprechende Programme werden längst genutzt, und ChatGPT dürfte erst den Anfang der diesbezüglichen Entwicklungen darstellen. Stattdessen erscheint daher eine Überarbeitung von Lehr- und Prüfungsformen geboten (vgl. Weßels et al. 2022). Ein gangbarer Weg könnte sein, KI-Anwendungen produktiv in die Lehre einzubinden (s.o.), Studierenden den Umgang mit solchen Programmen zu vermitteln und sie auf Möglichkeiten, aber auch Probleme und Limitationen aufmerksam zu machen, die das Arbeiten mit ihnen mit sich bringt.

Ein erster wichtiger Schritt muss daher sein, textgenerierende KI in Seminaren und Einführungskursen zum wissenschaftlichen Arbeiten zu behandeln, so wie wir Studierende aktuell auch schon hinsichtlich eines kritischen Umgangs mit Internetquellen oder Wikipedia sensibilisieren. So ist das Verfassen von Seminar- oder Hausarbeiten, das sich nur auf ChatGPT stützt, wenig praktikabel, nicht nur weil das Programm keine echten Literatur- bzw. Quellennachweise, sondern selbstgenerierte Verweise erstellt und damit nicht nur Artefakte im Sinne erfundener Inhalte generiert, sondern auch, da zumindest die frei zugänglich Version auf veraltete Informationen zurückgreift und da die Software keinen Zugang zu wissenschaftlichen Artikeln akademischer Journals hat. Schließlich ist der ausgegebene Text auch nur so gut wie der Prompt, auf den hin er erstellt wurde – für differenzierte und profunde Texte ist bereits eine gewisse Sachkenntnis in dem entsprechenden Forschungsgebiet erforderlich .

Eine Lösung könnte sein, die Fragestellung von Hausarbeiten möglichst spezifisch zu gestalten und sie interaktiv gemeinsam mit den Studierenden weiterzuentwickeln, also das Entstehen einer Hausarbeit engmaschiger zu begleiten. Auch dies bedeutet natürlich einen erhöhten Betreuungsaufwand. Auch wenn es für die Gestaltung engagierter Lehre selbstverständlich scheint, ist es jetzt um so mehr geboten zu versuchen, bei den Studierenden Begeisterung für eine selbstständige Auseinandersetzung mit den Seminarinhalten zu inspirieren. Das kann sowohl über ansprechend und herausfordernd Aufgabenstellungen als auch über Etablierung von Feedbackschleifen gelingen (was allerdings auch den Betreuungsaufwand erhöht).

Für Klausuren ist zu Überlegen zukünftig wieder in der (aufwändig zu korrigierenden) Pen&Paper-Variante oder “online in Präsenz” im speziellen, nur Zugang zum jeweiligen universitätseigenen Intranet ermöglichenden Rechnerräumen stattfinden sollen. Eine weitere Möglichkeit wäre, auf mündliche Prüfungen auszuweichen – dies brächte allerdings einen erheblichen Zeitaufwand mit sich und würde de facto die Gelegenheiten für Studierende, wissenschaftliches Schreiben zu üben, reduzieren. Gleichzeitig ließen sich hier jedoch wichtige Kompetenzen überprüfen, wie etwa das Fachverständnis oder ob die Studierenden in der Lage sind, Transferleistungen zwischen den in den Seminaren erarbeiteten Inhalten und eigenen Alltagsbeobachtungen herzustellen.

In diesem Text konnten nur einige der Herausforderungen und Potentiale vom Einsatz von KI-gestützen Programmen umrissen werden. Dieser Blogeintrag soll eine vertiefte Auseinandersetzung mit Programmen wie ChatGPT anstoßen. Dafür laden wir zu weiteren Diskussionsbeiträgen auf diesem Blog ein. Diese könnten sich beispielsweise um folgende Fragen drehen:

- Was bedeutet der Einsatz von large language models für unsere Wissensproduktion in einem geisteswissenschaftlichen Fach, das sich über das Schreiben definiert?

- Welche Auswirkungen und Potentiale haben bildgenerierende machine learning Programme für die visuelle Anthropologie?

- Gibt es Best Practice Bsp. wie ChatGPT bereits in empirisch-kulturwissenschaftlicher Lehre eingesetzt wird?

- Welche Auswirkungen hat es für die Forschung, wenn MaxQDA KI-generierte Code Summarys anbietet?

- Wie verändert KI-gestützte Textrezeption, etwa durch die Nutzung von durch KI-Anwendungen erstellten Zusammenfassungen, unser Lesen und Nachdenken über Inhalte? Anders gefragt: kann ChatGPT einen Text gegen den Strich lesen?

Best Practice und Verfahrensweisen anderer Universitäten

Der Umgang mit ChatGPT ist bereits Thema an zahlreichen Hochschulen. Einige von ihnen haben den Weg einer stark eingeschränkten Nutzung gewählt (z.B. siehe Tübingen), andere wie das Pariser Institut für Politikwissenschaft (Sciences Po) haben die Verwendung gar gänzlich untersagt. Eine umfangreiche kommentierte Linksammlung und ein Dossier zu ChatGPT in der Lehre hat das Hochschulforum Digitalisierung zusammengetragen.

Literatur:

Dippel, Anne (2017): Das Big Data Game. Zur spielerischen Konstitution kollaborativer Wissensproduktion in der Hochenergiephysik am CERN. In: NTM. Zeitschrift für Geschichte der Wissenschaften, Technik und Medizin 25 (4), S. 485–517. Online unter: https://link.springer.com/article/10.1007/s00048-017-0181-8

Dippel, Anne (2021): Schwindel in der Digitale. Re/Visionen einer Kulturanalyse des Alltags. In: Rebecca Carlson u.a. (Hg.): Code. Kuckuck. Notizen zur Alltagskultur 21 (1), S. 6–10.

Fleischmann, Andreas (2023): ChatGPT in der Hochschullehre. Wie künstliche Intelligenz uns unterstützen und herausfordern wird. In: Neues Handbuch Hochschullehre. Online unter: https://www.nhhl-bibliothek.de/de/handbuch/gliederung/#/Beitragsdetailansicht/243/3700/ChatGPT-in-der-Hochschullehre—Wie-kuenstliche-Intelligenz-uns-unterstuetzen-und-herausfordern-wird dippel

Linde, Helmut (2023): So funktioniert ChatGPT. In: golem.de vom 06.02.2023. Online unter: https://www.golem.de/news/kuenstliche-intelligenz-so-funktioniert-chatgpt-2302-171644.html (Stand: 22.08.2023).

Mittelstaedt, Max (2023): GPT Zero AI Detector für ChatGPT im Test (Deutsch). Videoupload am 07.06.2023. Online unter: https://www.scientific-economics.com/gpt-zero-chatgpt-ai-detector-im-test/ (Stand: 22.08.2023).

Mollick, Ethan (2023): My class required AI. Here‘s what I‘ve learned so far. In: One Useful Thing vom 17.02.2023. Online unter: https://www.oneusefulthing.org/p/my-class-required-ai-heres-what-ive

Perrigo, Billy (2023): Exclusive: OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic. In: Time vom 18.01.2023. Online unter: https://time.com/6247678/openai-chatgpt-kenya-workers/ (Stand: 22.08.2023).

Salden, Peter/Leschke, Jonas (Hg.:) (2023): Didaktische und rechtliche Perspektiven aus KI-gestütztes Schreiben in der Hochschulbildung. Ruhr-Universität Bochum. Online unter: https://doi.org/10.13154/294-9734 (Stand: 22.08.2023).

Snyder, Kieran (2023): We asked ChatGPT to write performance reviews and they are wildly sexist (and racist). In: Fast Company vom 03.02.2023. Online unter: https://www.fastcompany.com/90844066/chatgpt-write-performance-reviews-sexist-and-racist (Stand: 22.08.2023).

Stede, Manfred (2023): Chatting Today. Von unschuldigen Alogorithmen zu stochastischen Papageien und mutigen Bullshit-Generatoren. In: mediendiskurs 27 (3), S. 12-17. Online unter: https://mediendiskurs.online/beitrag/chatting-today-beitrag-1140/

Weimann-Sandig, Nina (2023): ChatGPT – Eine Chance zur Wiederbelebung des kritischen Denkens in der Hochschullehre“. In: Hochschulforum Digitalisierung vom 16.2.2023. Online unter: https://hochschulforumdigitalisierung.de/de/blog/praxistest-chatgpt-weimann-sandig (Stand: 22.08.2023).

Weßels, Doris/Mundorf, Margret/Wilder, Nicolaus (2022): ChatGPT ist erst der Anfang. Über den Einsatz generativer KI-Sprachmodelle im Bildungskontext. Online unter: https://hochschulforumdigitalisierung.de/de/blog/ChatGPT-erst-der-anfang

Weßels, Doris (2023): Was ist ChatGPT und wie funktioniert es? – Und welche ähnlichen Tools gibt es? Vortrag bei Deutsche Gesellschaft für Hochschuldidaktik, 29.01.2023. Online unter: https://www.youtube.com/watch?v=cMuBo_rH15c&t=2s (Stand: 22.08.2023).

Zum Weiterlesen:

Kabel, Claudia (2023): Studie zu KI. In: Frankfurter Rundschau vom 03.07.2023, Online unter: https://www.fr.de/rhein-main/darmstadt/studie-zu-ki-so-nutzen-studierende-chat-gpt-und-co-92374633.html?xing_share=news

Loser, Philipp (2023): Unis zittern vor Chat-GPT. In: Tagesanzeiger vom 04.07.2023. Online unter: https://www.tagesanzeiger.ch/unis-zittern-vor-chat-gpt-diese-berner-professorin-wagt-ein-experiment-142577951107

Turnitin (2023): Guide for approaching AI-generated text in your classroom. Online unter: https://www.turnitin.com/papers/guide-for-approaching-ai-generated-text-in-your-classroom

Abbildungsverzeichnis:

Abb1.: Erstellt mit Midjourney. Prompt: a black and white photograph of two women talking to a robot. 1920s, exotic, flickr, light brown and indigo, ordinary scenes

Abb. 2: Erstellt mit Midjourney. Prompt: students using AI for their homework

[1] Dass diese Geschichte auch eng mit der Praxis des Schwindelns verknüpft ist zeigt Dippel 2021.

[2] ChatGPT ist aktuell nur der Chatbot, dem die größte Aufmerksamkeit zuteilwird. Auch die Systeme von Google (Bard), Meta (Llama bzw. Alpaca AI) und AlephAlpha (Luminous bzw. Lumi) sind ähnlich leistungsstark in der Generierung von plausiblen Text (Fleischmann 2023, S. 3).

[3] Um ChatGPT hinsichtlich dieser moralischen Setzungen zu trainieren, wurden menschliche Arbeitnehmer:innen in Kenia für einen Stundenlohn von weniger als 2$ beauftragt, Beschreibungen zu klassifizieren, die sich unter anderem um Kindesmisshandlung, sexuelle Übergriffe oder Tierquälerei drehten (Perrigo 2023).

[4] Für diesen Hinweis danken wir Wolfgang Meixner.